HTTrack es un software freeware, tanto para sistemas Windows como para Linux, que nos permitirá descargar un sitio Web por completo a un directorio local de nuestro equipo. Construye recursivamente todos los directorios, consiguiendo HTML, imágenes y otros archivos desde el servidor a tu equipo.

|

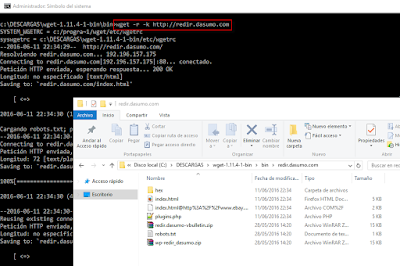

| Figura 1: HTTrack descargando una website de ejemplo. |

Una vez descargado todo el website, podremos navegador de forma local sin conexión a Internet o a ese sitio web, navegar entre todos los hipervínculos de dicha website.

Dependiendo el "tamaño" que pueda tener el sitio web a descargar el proceso tardará más o menos tiempo, aunque esto dependerá también del tipo de conexión a Internet que tengamos.

Para hacerse una idea unos 330MiB tardaríamos unas 4 horas en descargar.

Cyotek WebCopy se trata de otro software con el que poder descargar un sitio web. Similar a HTTrack. Admite URLs con esquema HTTPS, estableciendo campos de formulario o login si se trata de un portal con autenticación previa.

|

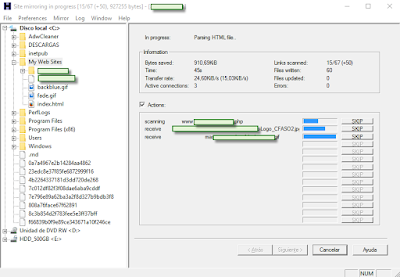

| Figura 2: Cyotek WebCopy descarga de sitio web. |

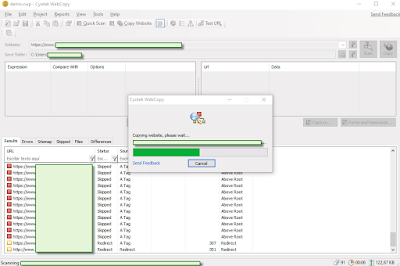

wget: Linux y Windows

Otra forma de poder descargar todo un website a nuestro equipo local es a través del uso de wget en sistemas Linux esta utilidad ya viene integrada por defecto.wget [WEBSITE] -r -k -page-requisites

|

| Figura 3: wget sobre Ubuntu. |

Algunos modificadores útiles de wget:

-r o -recursive: indica que de forma recursiva profundice en el árbol de directorios del sitio remoto.

-k o -html-extension: convierte todas las extensiones de fichero a .html.

-page-requisites: descarga absolutamente todo lo que necesite cada página web (imágenes, CSS, etc…).

-no-clobber: evita re-descargar archivos que ya se hubieran descargado.

-convert-links: convierte los enlaces a fichero local, de modo que pueda navegar por todos los hipervínculos de forma local, offline.

-domains [Website]: no descargará ningún enlace o nada que se salga del dominio indicado.

-no-parent: no subirá a niveles superiores al dominio

Figura 4: wget sobre Windows.

Descargar wget para Windows: http://gnuwin32.sourceforge.net/packages/wget.htm

Después de descargarlo y ejecutarlo seguramente nos pedirá las siguientes librerías:

libssl32.dll y libeay32.dll: https://openvpn.net/release/openssl

libintl3.dll: http://gnuwin32.sourceforge.net/packages/libintl.htm

libiconv2.dll: http://gnuwin32.sourceforge.net/packages/libiconv.htm

Saludos!